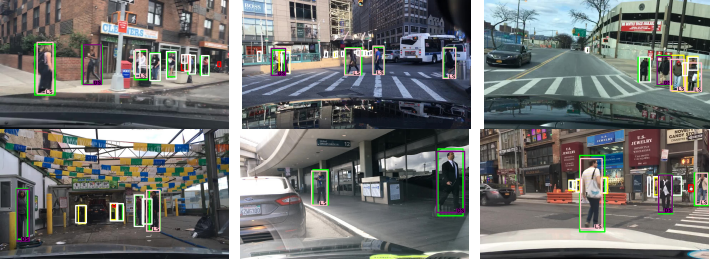

Rastistično nastrojeni razvijalci ali napake v sistemu? To je vprašanje, na katerega bodo morali odgovoriti pri razvijcalcih AI sistemov za zaznavanje objektov v samovozečih avtomobilih, ki se zelo hitro uveljavljajo.

Po najnovejših raziskavah inštituta tehnologije v zvezni državi Atlanta, Georgija so namreč sistemi z umetno inteligenco, ki so namenjeni predvidevanju nevarnosti kar površni. Testiranja so potekala po dnevi in ponoči in so se na koncu izkazala za zelo netočna.

V kar 5 odstotkih primerov sistem ni zaznal temnopoltih ljudi, ki so hoteli prečkati cesto in se samovozeči avtomobil ni ustavil. Na inštitutu so pojasnili, da je sicer problem rešljiv z integracijo večih slik v podatkovni sistem, saj bi s tem senzorji lažje prepoznali tudi temnopolte ljudi.

Težava sicer ni tuja, saj je znana že iz sistemov za prepoznavanje obrazov, kjer imajo omenjeni sistemi težave s prepoznavanjem obrazov temnopoltih ljudi in ljudi, ki nimajo običajnega obraza oz. so slikani s strani. So torej takšni sistemi sploh zanesljivi in ali je tehnologija že zadostno pripravljena za tovrstne primere?